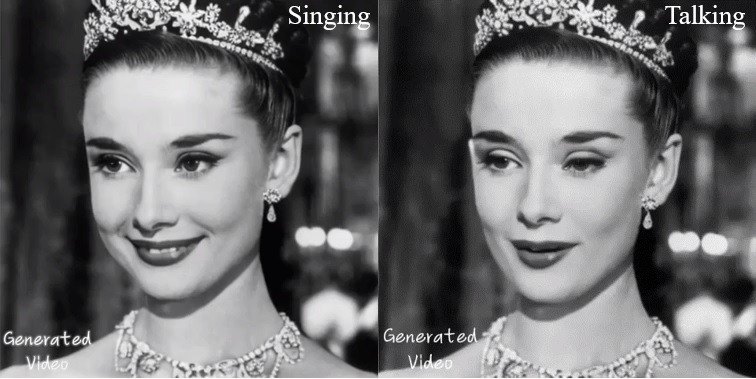

Cada semana hay una nueva solución de inteligencia artificial que nos sorprende a todos. Esta semana le toca al Institute for Intelligent Computing del grupo Alibaba, que ha anunciado una solución que se llama Emote Portrait Alive. Esta solución requiere de una imagen tipo retrato y un texto, EMO se encarga de generar un vídeo haciéndole pronunciar el texto que se ha suministrado. EMO puede hacer que la imagen hable o cante y la sincronización de los labios con el texto es increíble. Una vez más es casi imposible de identificar que se trata de un vídeo generado por una inteligencia artificial.

Vamos a ver un ejemplo que se entiende mejor

EMO puede generar videos sin límite de duración, la duración está ligada a la longitud del texto que se suministra. EMO no solo sincroniza los labios con el texto, sino que también tiene expresiones faciales y gestos que hacen que el vídeo sea hiperrealista.

¿Como funciona EMO?

Funciona en dos etapas, la primera denominada codificación de cuadros, se implementa la red de referencia para extraer características de la imagen de referencia y los cuadros de movimiento. En la segunda etapa llamada de proceso de difusión, un codificador de audio preentrenado procesa la incrustación de audio. La máscara de la región facial se integra con ruido para la generación de las imágenes faciales. A esto le sigue el empleo de la red troncal para facilitar la operación de denoising (quitar el ruido).

EMO pude hablar o cantar en varios idiomas y como hemos dicho antes tiene diferentes movimientos de cabeza que se acompasan a los movimientos vocales y faciales. También es capaz de realizar variaciones en el tono vocal dependiendo de la canción o el texto que se le proporciona.

Este ejemplo de Leonardo DiCaprio rapeando es increíble

EMO no solo puede realizar la animación con fotos, también puede tratar pinturas o modelos en 3D. Los desarrolladores entrenaron el modelo con un conjunto de datos de más de 250 horas de vídeos de “cabeza parlante” (vídeos que solo muestran la cabeza y hombros de una persona hablando) cuidadosamente seleccionados de discursos, películas, programas de televisión y actuaciones musicales.

EMO directamente convierte la forma de onda del audio en fotogramas de vídeo. Esto le permite capturar movimientos sutiles y particularidades específicas de la identidad asociados con el habla natural. Según el estudio realizado por los desarrolladores, EMO supera significativamente a los métodos actuales existentes en métricas que miden la calidad del vídeo, la preservación de la identidad y la expresividad. Los investigadores también realizaron un estudio de usuarios que encontró que los vídeos generados por EMO eran más naturales y emotivos que los producidos por otros sistemas.

No me puedo resistir os dejo un último vídeo

Los desarrolladores de EMO nos dan una imagen de un futuro en el que el contenido de video personalizado se puede sintetizar a partir de tan solo una fotografía y un texto o un archivo de audio. Sin embargo, como ya he evocado en precedentes artículos relacionados con la inteligencia artificial, persisten las preocupaciones éticas sobre el posible uso indebido de esta tecnología para suplantar a las personas sin su consentimiento o difundir información falsa. Como ya anuncio la semana pasada OpenAi con Sora, los desarrolladores de EMO se planean explorar métodos para detectar videos sintéticos (generados por inteligencia artificial).

Conclusión

EMO se coloca a la vanguardia de la innovación en medios digitales, ofreciendo nuevas posibilidades para animar personajes con un realismo sin precedentes. Este proyecto demuestra el potencial de la Inteligencia Artificial para transformar imágenes estáticas en videos atractivos y dinámicos, allanando el camino para futuros avances en la comunicación digital y la expresión creativa.